반응형

Convolutional Neural Networks의 기본

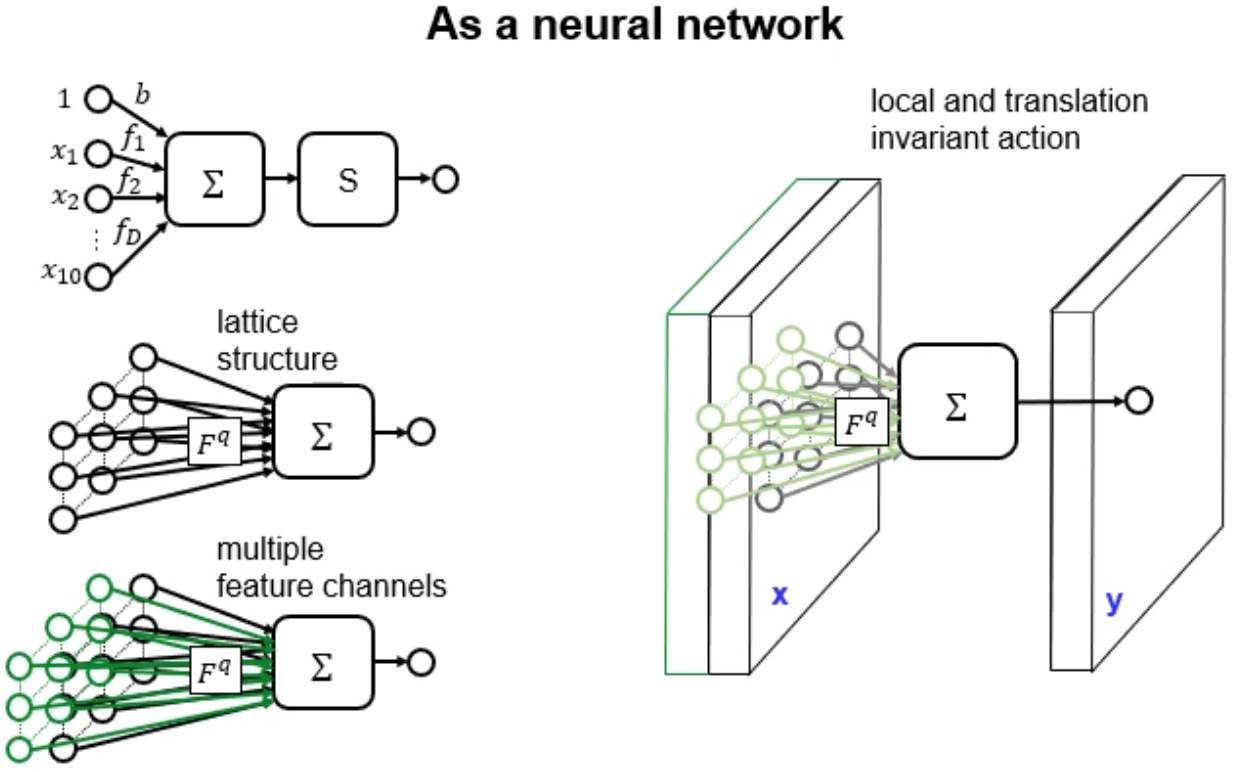

Convolution Neural Networks

- weights와 biases를 가진 neurons(nodes)으로 구성되어있다.

- 각 neuron은 input을 받아 dot product(내적 연산)을 수행한 후에 비선형 함수에 통과시킨다

- 미분가능한 score func→ Loss func을 최소화 하는 방향으로 진행한다. input은 raw image pixels이다

The Activations of an example convnet architecture

- ConvNet(Convolution Networks) architecture

- INPUT → CONV → RELU → POOL → FC

- INPUT : ex. 32x32x3(width x height x channel) 과 같은 3차원 data 구조, raw pixel values of image

- CONV layer : input의 local regions과 내적연산을 진행한다.(12filter를 사용할 경우 32x32x12)

- RELU layer : activation func. 크기가 변하지 않는다.(32x32x12)

- POOL layer : width, height를 downsampling을 하여 크기를 줄여준다.(16x16x12)

- FC(Fully-Conneted) layer : class score를 계산하는 layer(1x1x10(class의 개수))

- INPUT → CONV → RELU → POOL → FC

Convolutional Layer

- CONV layer's parameters 학습가능한 filter weights의 집합이다.

- filter는 input의 width, height보다는 작고, depth(채널 개수)는 같다.

- 순전파 진행하면서 filter는 sliding하면서 내적연산을 진행하여 activation map을 만든다.

Spatial Arrangement(1/2)

- ouput의 size를 control하는 3개의 hyperparameters : depth, stride, zero-padding

- depth : filter의 개수, 각각의 filter는 입력값의 차이점을 찾기 위한 학습을 한다.

- stride : convolution연산을 할때 filter를 몇 pixel만큼 옮기는지에 대한 parameter, stride가 클 수록 output의 크기는 작아진다

- zero-padding

- output의 size를를 조정하기 위해 input의 외곽에 0을 붙이는 것.

- Spatial 크기 = (W-F+ 2P)/S+1

- W : function of the input volume size

- F : number of filter

- S : the stride with which they are applied

- P the amount of zero padding used on the border.

Pooling layer

- Conv layer 사이에 넣어준다.

- conv layer를 통과하고 나온 activation map의 크기를 줄여줄여 주어 parameter의 양과 computation의 양을 줄여주어 Overfitting을 방지하는 효과를 준다.

- input의 각 depth에 대하여 Independently(독립적으로) 연산을 하고 resize한다. max pooling이 많이 사용됨

Normalization/Fully-Connected Layer

- normalization layers는 정규화 시키는 과정이 conv에서 효과가 별로 없어서 많이 사용하지 않는다.

- Fully-Connected layer : 이전 layer의 Node와 현재 Node간에 완벽하게 연결된 layer이다.

- fc의 활성화는 matrix의 곱과 bias offset으로 계산될 수 있다.

Detail of Convolutional Neural Networks

Convolutional neural networks (CNNs)

- c1 ~ c5 : conv layer

- f6 ~ f8 : FC layer

- 왼쪽에서 오른쪽으로 진행

- 입력 영상의 해상도 감소(크기 감소)

- 특징점은 증가

- FC layers의 역할

- convolution 연산을 수행, 하지만 1 x 1 연산을 한다.

- 대부분의 parameter를 포함하고 있다.

Convolutional Layers

- linear filters에서 convolution 연산을 실행 (F*x + b)

- non-linear gating : 활성화 함수 RELU를 사용

- Pooling : max pooling과정 진행

- channel normalisation : 활용하지 않음

A signal processing notation

- Data and intermediate neural computations are discrete vector fields

- tensor : 모든 차원의 데이터 포함

Linear convolution

- input x : H x W x K array

- filter bank F = H` x W` x K x Q array (Q : filter의 개수)

- output y : (H-H`+1) x (W-W`+1) x Q array

Gating(Activation) functions

- sigmoid는 vanishing gradient가 발생(역전파 신호가 사라지는 현상)

Multiple layers

- filter를 거치고 non-linear operator를 통과한다.

- 이러한 과정을 계속 반복 → layer를 쌓는다.

- Downsampling은 pooling 과정에서 진행한다.

Local contrast normalisation

Spatial pooling

max, sum, avg, L-sum등 다양한 pooling 방법이 있다.

반응형

'AI > DeepLearning' 카테고리의 다른 글

| DeepLearning에 사용되는 Activation Function 정리 (0) | 2021.07.18 |

|---|---|

| DNN(심층신경망) (3) | 2021.07.14 |

| ANN(인공신경망) (0) | 2021.07.12 |

| Introduction to Deep Learning (2) | 2020.10.19 |